Il cervello nascosto dell’intelligenza artificiale

Il cervello è ancora il re dei computer. Le macchine più sofisticate basate su di esso, note come macchine “neuromorfiche”, contengono oggi fino a 100 milioni di neuroni — tanti quanti il cervello di un piccolo mammifero. Queste reti artificiali di neuroni e sinapsi sono alla base dell’intelligenza artificiale. Possono essere emulate in due modi: o con simulazioni al computer, o con componenti elettronici che riproducono i neuroni e le sinapsi biologiche, assemblati in “neuroprocessori”. Questi approcci software e hardware sono ora compatibili e aprono la strada a drastici sviluppi nel campo dell’intelligenza artificiale.

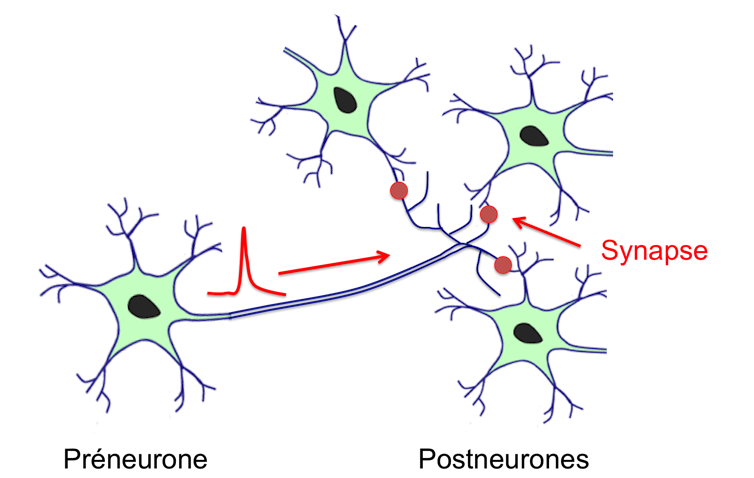

La corteccia è lo strato più esterno del cervello. Spessa pochi millimetri e grande come un tovagliolo, contiene più di 10 miliardi di neuroni che elaborano informazioni sotto forma di impulsi elettrici chiamati “potenziali d’azione” o “spike”. Il punto di connessione tra un neurone che emette un picco (il preneurone) e il neurone che lo riceve (il postneurone) è la sinapsi. Ogni neurone è collegato da sinapsi a circa 10.000 altri neuroni: la connettività di tale rete, il connettoma, è quindi prodigiosa.

La funzione dei neuroni è fissa: consiste nel sommare i segnali provenienti dalle sinapsi e, se questa somma raggiunge una soglia, generare un potenziale d’azione o spike che si propagherà nell’assone. È notevole notare che una parte dell’elaborazione è analogica (la somma dei segnali sinaptici è continua), mentre l’altra è binaria (la risposta neuronale è o la generazione di uno spike o nulla). Il neurone può quindi essere considerato come un computer analogico associato a un sistema di comunicazione digitale. A differenza dei neuroni, le sinapsi sono plastiche, cioè possono modulare l’intensità del segnale trasmesso al postneurone, e hanno un effetto “memoria”, perché lo stato di una sinapsi può essere conservato nel tempo.

Da un punto di vista anatomico, la corteccia è divisa in circa un milione di colonne corticali, che sono reti di neuroni tutte con la stessa architettura di interconnessione. Le colonne corticali possono essere considerate come processori elementari, con i neuroni come dispositivi di base e le sinapsi come memoria. Da un punto di vista funzionale, le colonne corticali formano una rete gerarchica con connessioni che vanno dal basso (sensori sensoriali) verso l’alto, consentendo astrazioni, ma anche dall’alto verso il basso, consentendo previsioni: i processori del nostro cervello lavorano in entrambe le direzioni.

La sfida principale dell’IA è emulare le funzionalità della corteccia con reti artificiali di neuroni e sinapsi. Questa idea non è nuova, ma negli ultimi anni è stata portata avanti con il deep learning.

L’approccio software mira a simulare reti neurali e sinapsi utilizzando un computer standard. Gli ingredienti sono tre: modelli matematici di neuroni e sinapsi, un’architettura per l’interconnessione dei neuroni e una regola di apprendimento per modificare i “pesi sinaptici”.

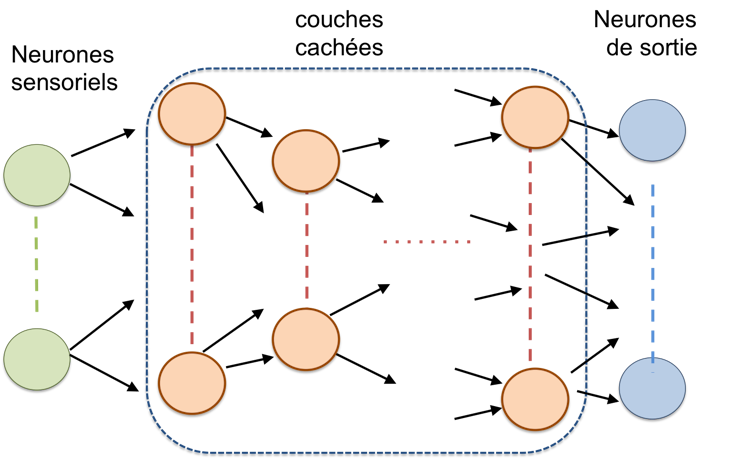

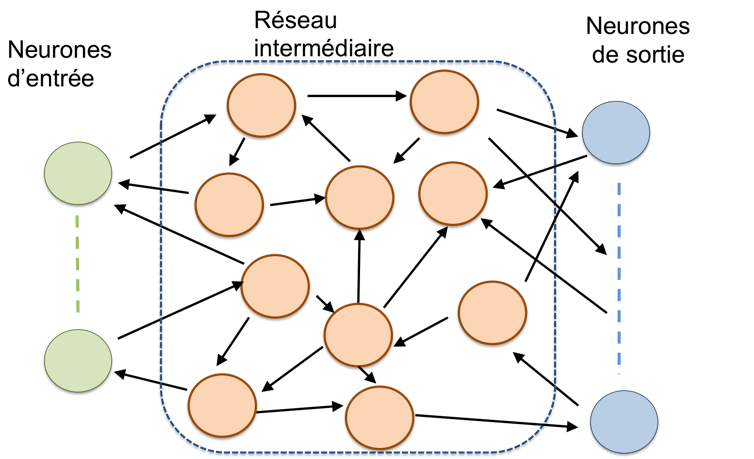

I modelli matematici dei neuroni vanno dai più semplici ai più realistici (dal punto di vista biologico), ma la semplicità è necessaria per simulare reti di grandi dimensioni – diverse migliaia o addirittura milioni di neuroni – al fine di limitare il tempo di calcolo. L’architettura delle reti neurali artificiali e delle sinapsi comprende generalmente uno “strato” di ingresso, contenente i “neuroni sensoriali”, e uno strato di uscita, i risultati. Tra i due, c’è una rete intermedia che può assumere due forme principali: “feedforward” o “ricorrente”.

Le reti neurali “ricorrenti” contengono anelli di retroazione. Nelle reti ricorrenti, la variabile “tempo” è un parametro essenziale.

Lo scopo dell’apprendimento è determinare il peso di ogni sinapsi, cioè l’intensità con cui lo spike da un pre-neurone viene trasmesso al post-neurone, in modo che la rete possa rispondere a un obiettivo definito. Esistono due tipi principali di apprendimento: supervisionato, quando un “insegnante” (o “maestro”) conosce il risultato atteso per ogni input, e non supervisionato, quando non esiste un tale “maestro”. Nel caso dell’apprendimento supervisionato, è il confronto tra il risultato ottenuto per un ingresso e quello del “maestro” che consente di regolare i pesi sinaptici. Nel caso dell’apprendimento non supervisionato, si utilizza una regola come la famosa regola di Hebb per modificare i pesi sinaptici nel corso di diverse prove.

L’approccio hardware prevede la progettazione e la produzione di neuroprocessori che emulano neuroni, sinapsi e interconnessioni. La tecnologia più avanzata si basa su semiconduttori standard (noti come CMOS), utilizzati nei nostri computer, tablet e smartphone. Attualmente questa è l’unica tecnologia sufficientemente matura per produrre circuiti contenenti migliaia o milioni di neuroni e sinapsi in grado di svolgere i compiti complessi richiesti dall’IA, ma si stanno proponendo anche tecnologie basate su nuovi dispositivi, ad esempio la spintronica o l’uso di memristori.

Come le reti biologiche, le reti di neuroni e sinapsi artificiali spesso combinano una parte analogica per l’integrazione dei segnali sinaptici e una parte digitale per le comunicazioni e la memorizzazione dei pesi sinaptici.

Questo tipo di approccio misto è utilizzato nelle tecnologie più avanzate, come i chip del progetto European Human Brain di Intel o TrueNorth di IBM. Il chip TrueNorth, ad esempio, combina un milione di neuroni e 256 milioni di sinapsi programmabili, suddivisi in 4.096 nuclei neuromorfici — simili alle colonne corticali degli organismi viventi — collegati tra loro da una rete di comunicazione. Il consumo energetico del chip TrueNorth è di 20 mW per cm2, rispetto ai 50-100 W per cm2 di un microprocessore convenzionale, con un risparmio energetico superiore a 1.000 (il modo abituale di considerare questo dato è quello di considerare la “densità di flusso di potenza”, perché non tutti i chip hanno la stessa superficie).

Le reti neurali artificiali e le sinapsi software forniscono soluzioni eleganti a molti problemi, in particolare nei campi dell’elaborazione di immagini e suoni e, più recentemente, della generazione di testi. Ma l’apprendimento delle reti neurali ricorrenti e delle sinapsi artificiali rimane una delle principali difficoltà, sia che si utilizzino metodi supervisionati che non supervisionati. Un altro problema è che la potenza di calcolo richiesta sta diventando considerevole per le reti neurali e le sinapsi artificiali su larga scala necessarie per risolvere problemi complessi.

Ad esempio, gli impressionanti risultati del programma di conversazione GPT-3 si basano sulla più grande rete di neuroni e sinapsi artificiali mai costruita. Ha 175 miliardi di sinapsi e richiede una notevole potenza di calcolo, costituita da 295.000 processori che consumano diversi megawatt di elettricità, pari a quella consumata da una città di diverse migliaia di abitanti. A fronte di pochi watt consumati da un cervello umano che svolge lo stesso compito!

L’approccio hardware e i neuroprocessori sono molto più efficienti dal punto di vista energetico, ma soffrono di una grande difficoltà: la scalabilità, cioè la produzione di diversi milioni o miliardi di neuroni e sinapsi e della loro rete di interconnessione.

In futuro, e nella misura in cui i neuroprocessori utilizzeranno la stessa tecnologia CMOS dei processori convenzionali, la co-integrazione degli approcci software e hardware potrebbe aprire la strada a un nuovo modo di concepire l’elaborazione delle informazioni, e quindi all’IA ad alte prestazioni e a basso consumo energetico.

Autore

Alain Cappy è professore universitario presso l’Università di Lille o ha insegnato l’elettronica, in particolare la fisica dei dispositivi a semiconduttori. Le loro attività di ricerca all’inizio riguardavano la concezione, la fabbricazione e la caratterizzazione rapida di micro e nano dispositivi.

Fonte: THE CONVERSATION

https://www.asterios.it/catalogo/la-mente-umana-e-la-mente-artificiale

https://www.asterios.it/catalogo/la-mente-umana-e-la-mente-artificiale